碳中和背景下的制冷技术应用

2023年9月7日,以“奋进新征程”为主题的2023数据中心全生命周期管理高峰论坛暨中国计算机用户协会数据中心分会第29届年会在青岛召开。国家气象信息中心副处长、数据中心分会专家委员孔令军在年会主论坛分享《碳中和背景下的制冷技术应用》,以下为演讲全文。

一、背景情况

2020年9月,我国在联合国大会上向全世界宣布,2030年实现碳达峰,2060年实现碳中和。碳达峰是指年度二氧化碳排放量达到历史最高值,然后经历平台期进入持续下降的过程,是二氧化碳排放量由增转降的历史拐点。碳中和是指通过植树造林、节能减排等形式,以抵消自身产生的二氧化碳排放量,实现二氧化碳“零排放”。我认为数据中心行业主要还是通过节能减排的方式来推动碳达峰、碳中和。

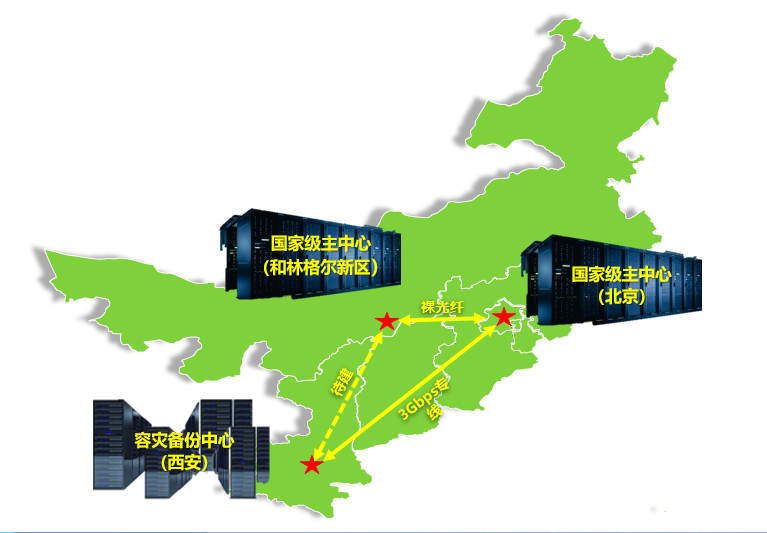

2022年2月,国家发展改革委等部门联合印发文件,同意在京津冀、长三角、粤港澳大湾区、成渝、内蒙古、贵州、甘肃、宁夏启动建设国家算力枢纽节点,并规划了和林格尔等10个国家数据中心集群,响应国家东数西算发展战略。2022年6月,中国气象局批复在和林格尔新区建设20P超算,实现气象行业算力的从东向西迁移。

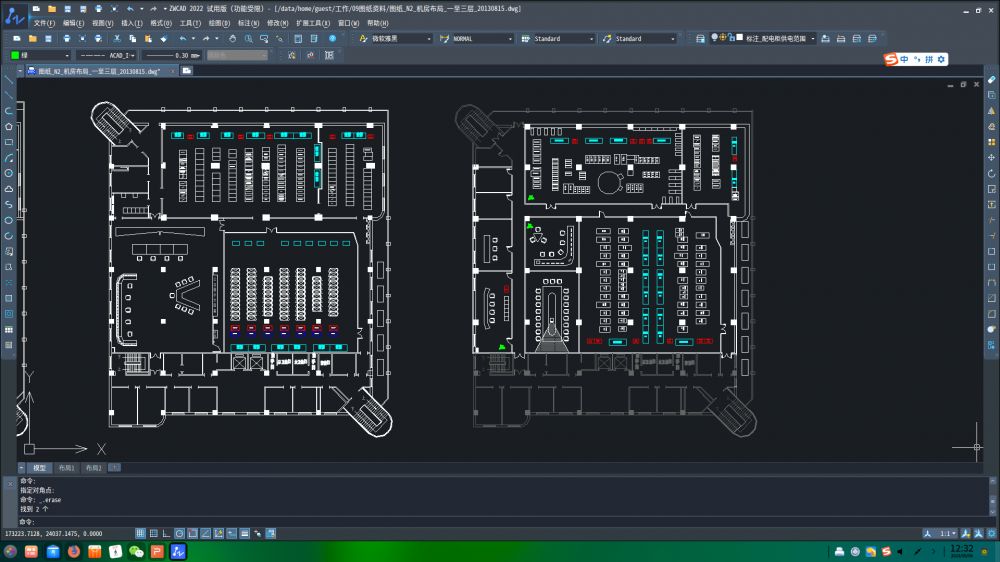

国家气象信息中心新一代气象高性能计算布局情况如图1 所示,从技术、气候,多管齐下来实现节能减排。

图1 新一代气象高性能计算布局

在北京国家级主中心,设置有26 PFlops+8 PFlops两套CPU架构系统,以及2 PFlops的技术架构超算系统,CPU架构系统的实际功耗分别达到3750kW和1240kW,采用以冷板液冷为主、风冷补充的方式。

和林格尔新区的超算主要是20PFLops的CPU架构系统,目前暂未运行,厂商提供功耗数据为3326kW,以冷板液冷为主,风冷补充。

同时在西安的容灾备份中心分别建了一套2PFLops的X86国产芯片超算和2PFLops的ARM国产芯片超算,计划用于一些科学研究,为未来的一个大规模应用做技术储备。

上述三地预计在2023年底全部建成并投入使用,从此形成新一代的气象高性能计算机布局。

二、制冷技术发展趋势

第二部分说一下制冷技术发展趋势,这里的讨论范围,主要限于国家气象信息中心多年以来应用过或调研过的技术,对于其他技术不做评论。

1. 氟利昂空调

从上世纪80年代国家气象信息中心就开始使用氟利昂精密空调,到现在为止一直在应用。目前的它的PUE平均能够达到1.65,行间空调PUE能提升至1.6以内。国家气象信息中心现在的所有机房的空间使用率都非常高,导致整个能源使用效率还是比较高的。

2. 冷冻水型空调

通过自然冷却的方式PUE可达1.4,行间空调模式可进一步提升,优缺点也是比较突出。在国家气象信息中心它主要协助于冷板液冷方式,作为补充。

3.水冷背板(RDHx)

当作过渡性产品使用,国家气象信息中心在2013年曾经应用,PUE可以达到1.3,整体运营效果还不错。

4.冷板液冷系统

这是国家气象信息中心现在最主要的应用和应用方式。优点是PUE可以达到1.2,但是缺点也比较突出,首先它应用范围受限,仅适用于高密度的IT设备;其次它需要高、低温两套制冷设施,系统复杂;整体的造价也比较高。这是目前相对比较节能的技术方案。

5.浸没液冷

这种方式国家气象信息中心从2017年就开始想要引入,但一直没有落地。浸没液冷的特点与冷板液冷有点类似,但是其高温水制冷的能力可达到95%以上,远高于冷板液冷80%的高温水制冷的带动量,所以它只需要极少量的空调辅助就能够运行,并且它的整体的系统比较简单,运行很可靠,PUE可做到1.1以内。

三、制冷技术应用情况

上述几种制冷技术在国家级安全中心的具体应用情况如下。

1. 2004年采用氟利昂空调

图2 机房配置平面图

(1)基本情况

2004年建设,使用氟利昂空调来支撑IBM Cluster 1600 HPC系统,系统规模是23TFlops,共54个机柜,最大单机柜额定功率54kW,实际27kW,实际总功耗630kW。

(2)制冷方式设计

全部采用风冷制冷,平面图见图2。机房内配置总冷量100kW、显冷量89kW机房精密空调14台,设计总冷量1246kW。机房气流组织被分成东西两部分,互相无法备份,各自实现6用1备运行模式。

(3)制冷设施运行情况

2013年氟利昂空调全部停机,运行仅10年,期间可用率为100%。10年间发生多次机房高温事件,最高一次环境温度达到40℃。

(4)经验教训

该制冷方式证明机房精密空调也能够满足高功率密度机柜(≥20kW)制冷需求。

但该方式能效比较低,实际制冷量不及设计制冷量的二分之一,也仅能满足基本运行要求。年均PUE约1.7,节能减排效果最差。如果空调布局能南北或东西对向布设,制冷效果会更好,但因参观需求未实现,对实际效果也有影响。

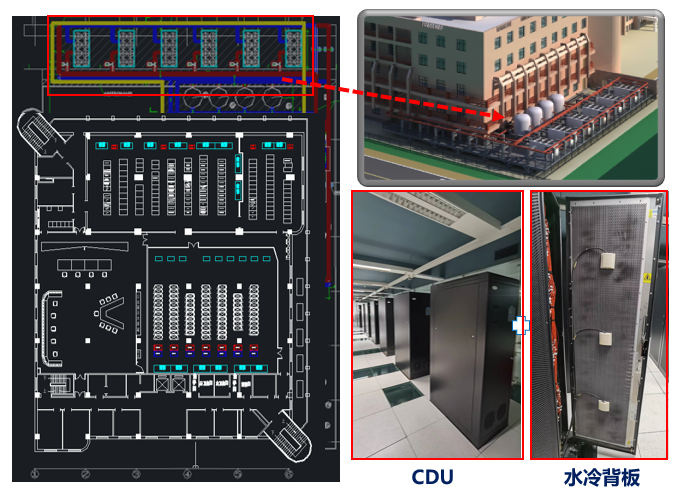

2. 2013年采用水冷背板

图3 水冷背板制冷方式

(1)基本情况

2013年国家气象信息中心采购IBM P460 HPC系统,用来替换之前的IBM Cluster 1600 HPC系统。HPC系统共76个机柜,单机柜最大额定功率56kW,实际24kW,实际总功耗1180kW。

(2)制冷方式设计

计算节点机柜采用水冷背板制冷方式,该方式能占到85%的热量,还有15%是需要机房精密空调来带走。在机房内配置了6台80kW机房精密空调,为风冷设备制冷。同时在室外配置6台530kW涡旋式风冷冷水机组提供一次侧冷水,前期采用4用2备,随着制冷效率的下降,后期配置为5用1备,12℃供水18℃回水。在机房内配置9台CDU为水冷背板提供二次冷水,15℃供水20℃回水。

(3)制冷设施运行情况

2023年设施停机,运行10年期间可用率达100%。

(4)经验教训

首先该制冷方式运行稳定,运行时机柜进出风温度基本相同,进出风均为21℃;再次其能效比相对是比较高的,所以在未采用自然冷却情况下,PUE能够低于1.4;第三是它的水冷背板后置于机柜,机柜内是一个标准机架,适应性相对是比较广的,适配超级计算机,预估也适配于普通计算机。造价相对于氟利昂空调略高。

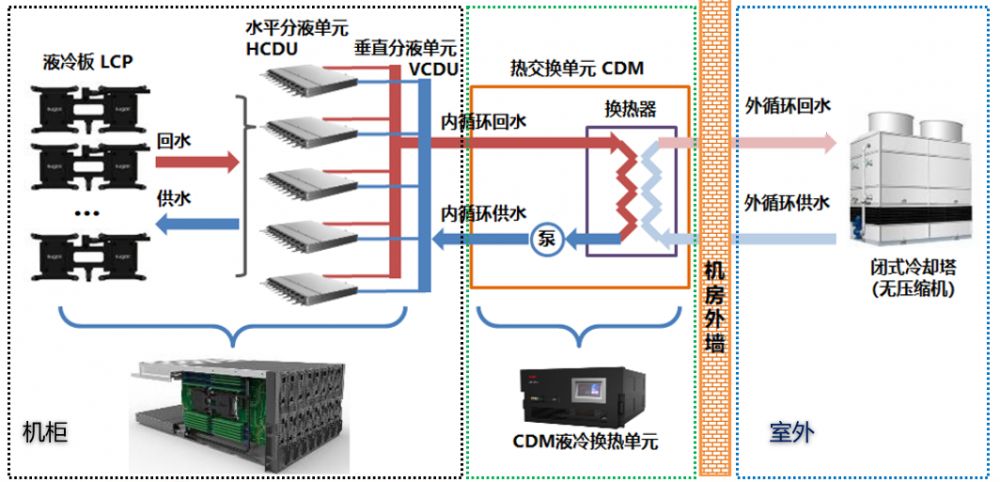

3. 2017年采用冷板液冷

图4 冷板液冷整体架构

(1)整体架构

冷板液冷系统整体架构由三部分组成,包括室外的冷却塔和一次水泵;机房内的CDM,它主要是由一个板块和一个二次循环泵组成;机柜内的一个垂直液冷单元、水平液冷单元,以及冷液、冷板、管道等相关设施。从整体系统架构可以看到它主要的功率器件就是冷却塔、一次和二次的循环水泵以及板式换热器,整个系统的运行是非常不错的。

(2)基本情况

2017年建设,支撑8PFlops曙光HPC系统,分为两个子系统;HPC系统共85个机柜,单机柜最大额定功率57kW,实际22kW,实际总功耗1240kW。

(3)制冷方式设计

子系统1全部采用风冷制冷,配置35台行间空调和4台冷冻水空调提供冷源;子系统2计算节点机柜采用冷板液冷制冷方式,比例达到80%,同时配置2台120kW冷冻水空调辅助制冷。此外,高温水系统配置2台冷却塔、2台循环泵和4台CDM,组成2N冗余架构;低温水系统配置3套2500kW冷水机组及板换,2用1备,为空调供冷水。

(4)制冷设施运行情况

2017年建成后至今已运行6年,期间可用率100%。

(5)经验教训

第一高温水系统运行非常稳定,至今仅发生过CDM过滤器脏堵、控制器件故障等个别情况,循环泵、冷却塔无故障发生,整体系统运行性能很高;第二该方式能效高,年均PUE1.2左右,冬季自然冷却情况下低于1.15;缺点是制冷设施造价昂贵。

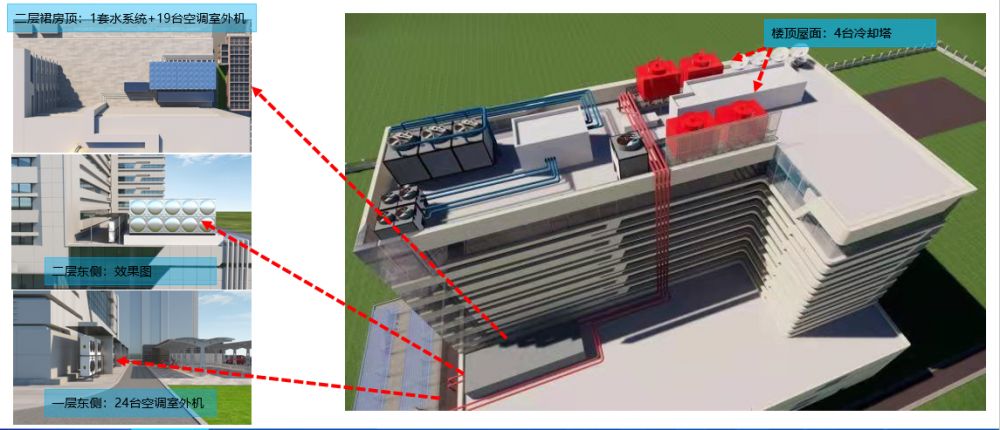

4. 2023年——冷板液冷

图5 冷板液冷应用

(1)基本情况

2023年建设,支撑26PFlops HPC系统,分为两个子系统。HPC系统共134个机柜,单机柜最大额定功率53kW,实际31kW。目前没有完全运行,估测实际运行最大功耗约3500kW,厂商提供实测数据为4540 kW。

(2)制冷方式设计

计算节点机柜采用冷板液冷制冷方式,比例达80%。每排机柜配置4至5台行间空调用于辅助制冷,机房统一配置3台精密空调保障机房环境;新建高温水系统,配置4台冷却塔、3台循环泵和16台CDM,组成一个冗余架构;低温水系统仍旧使用原有“2+1”低温水系统。

(3)制冷设施运行情况

于2023年4月开始投入运行,目前运行正常。

(4)经验教训

因为没有建设低温水冷源,所以单位造价比较低。

图6 室外制冷设施布局

图6可见新建的高温水系统以及整体的室外制冷设施布局与架构。屋顶配置了4台冷却塔,其次在二层裙房新建房屋配置一套水系统及19台空调室外机。这为了弥补低温水系统风冷负荷制冷量不足的问题,新建了一部分精密空调来补充风量。

四、想法和建议

在碳达峰、碳中和的背景下,除去个别小型数据中心,传统氟利昂空调的逐步退出是大势所趋。

冷冻水型空调作为独立冷源或者作为水冷背板、液冷等制冷能力的补充,将继续为数据中心长期服务。通过合理的数据中心选址和空调冷源设计,可以不断降低能耗。

水冷背板技术虽然应用时间窗口短、范围小,对产品和施工质量的要求较高,但是通用性强、成本适中,机架功率密度适应范围广,并且节能效果较好,所以我认为具有一定的保留和推广价值。

液冷技术虽然代表着未来的发展方向,但是该技术与服务器产品高度绑定、通用性差、竞争性不足,前期设计和招标采购难度大,通用性还需要进一步提升。

国产芯片服务器实际运行功耗增加明显,目前按照单机柜实际功耗8-10kW设计,相较于进口芯片服务器6kW/机柜功耗,提升50%左右。

对于其他一些制冷技术,因为不曾应用,不敢妄评,希望多沟通交流。谢谢各位专家和嘉宾的聆听。